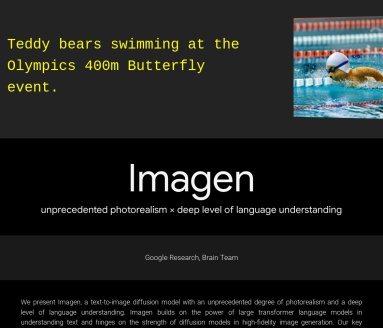

我們展示了Imagen,這是一種文本到圖像的擴散模型,具有前所未有的逼真度和深層次的語言理解能力。

Imagen 建立在大型 Transformer 語言模型理解文本的能力之上,並依賴於擴散模型在高保真圖像生成方面的優勢。

我們的主要發現是,在純文本語料庫上預訓練的通用大型語言模型(例如 T5)在為圖像合成編碼文本方面出奇地有效:增加 Imagen 中語言模型的大小可以大大提高樣本保真度和圖像-文本對齊 不僅僅是增加圖像擴散模型的大小。

Imagen 在 COCO 數據集上獲得了 7.27 的最新 FID 分數,而無需對 COCO 進行任何訓練,並且人類評分者發現 Imagen 樣本在圖像文本對齊方面與 COCO 數據本身不相上下。

為了更深入地評估文本到圖像模型,我們引入了 DrawBench,這是一個全面且具有挑戰性的文本到圖像模型基準。

通過 DrawBench,我們將 Imagen 與最近的方法(包括 VQ-GAN+CLIP、潛在擴散模型和 DALL-E 2)進行比較,發現人類評分者在並排比較中更喜歡 Imagen,無論是在樣本質量方面 和圖文對齊。

相關導航

暫無評論...